Más de un cryptoboy debe estar usando su rig para modelar p0rn ahora que minar no rinde. Los requerimientos son altos incluso para PCs gamer. Yo ni lo voy a intentar, mi máquina se cuelga en la instalación.

Aunque...

«Para nardos: hay uno entrenado con imágenes del JWST y cosas así del espacio y uno puede generar galaxias nuevas»

... es tentador, no voy a negarlo.

Cómo instalar Stable Diffusion y crear tus propias imágenes AI

Por insistencia de uno de ustedes (Gracias Ale!) me puse a jugar con Stable Diffusion de forma local, más que nada para probar si mi hardware era suficiente.

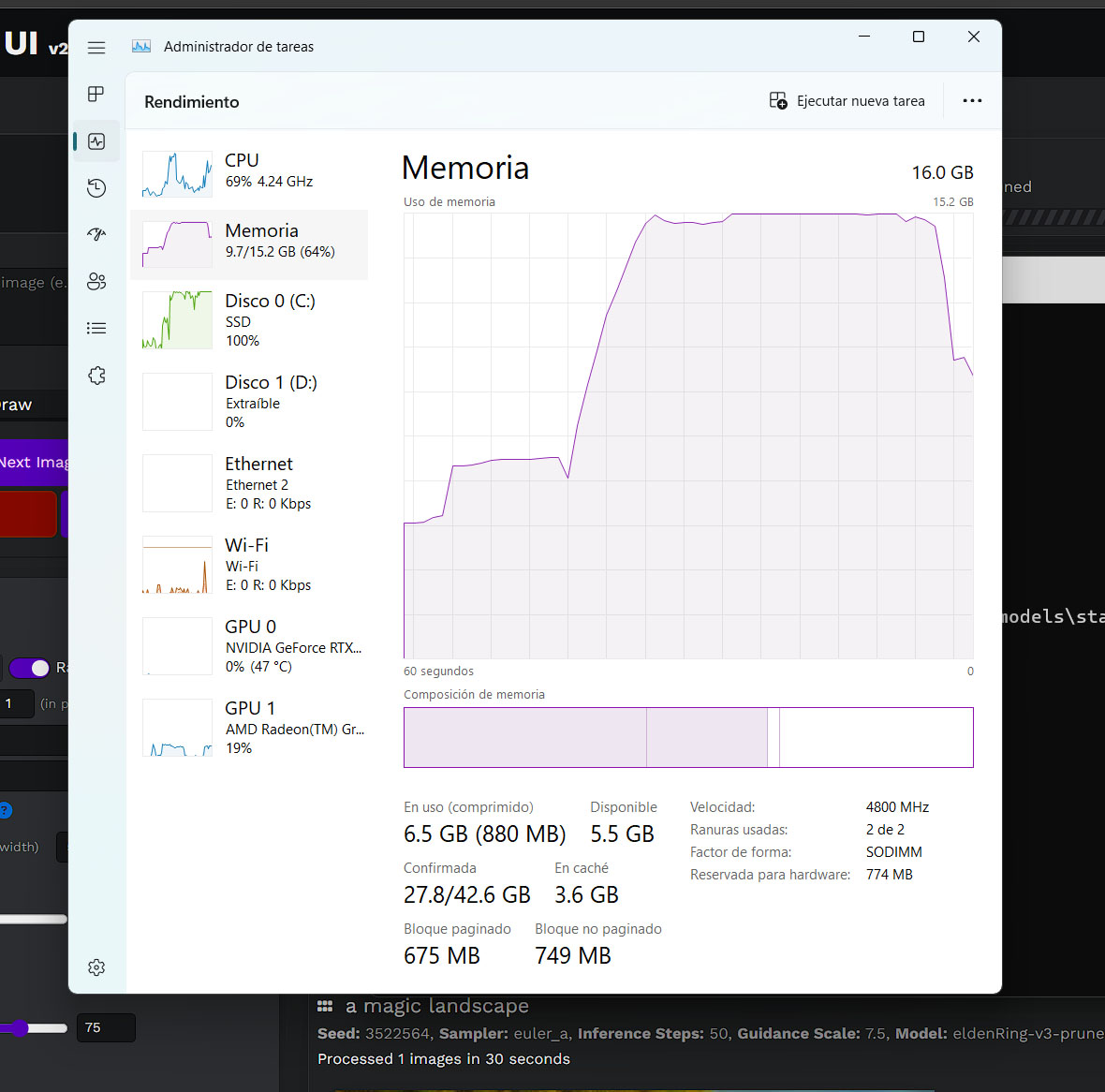

Puedo asegurar que NO, no lo es, pero no porque no funcione sino porque los nuevos modelos exigen cada vez más memoria RAM y, si uno quiere generar algo interesante, ni la placa de video que tiene alcanzará.

Peeero, para aquellos curiosos, aquí les explico cómo instalarlo y dónde conseguir modelos, y sí, se van a divertir un buen rato!👍

Hardware

Primero que nada el hardware necesario:

- Una PC relativamente moderna en CPU

- MUCHA MEMORIA RAM, 16GB es muy poco, hablamos de 32GB en adelante

- Una placa de video tipo RTX 2080 en adelante (se puede con algo menor también)

- VRAM, porque si algo necesitan estos modelos matemáticos es usar mucha VRAM, con 6GB de VRAM te quedás corto para los modelos más nuevos que requieren más de 10GB, por ende hablamoso de placas 3080 o 4080, o hacer imágenes muy pequeñas

- Al menos 40GB libres porque la instalación base pesa como 27GB más los modelos de 4GB a 8GB cada uno que sumes

Como verán es un requerimiento alto, especialmente en el GPU, usa mucha memoria de video y no siempre funcionará, el debugging es horrible y requiere mucho conocimiento extra de python para que todo ande. Aun así la instalación base es totalmente usable (con resultados mediocres, claro).

Instalación

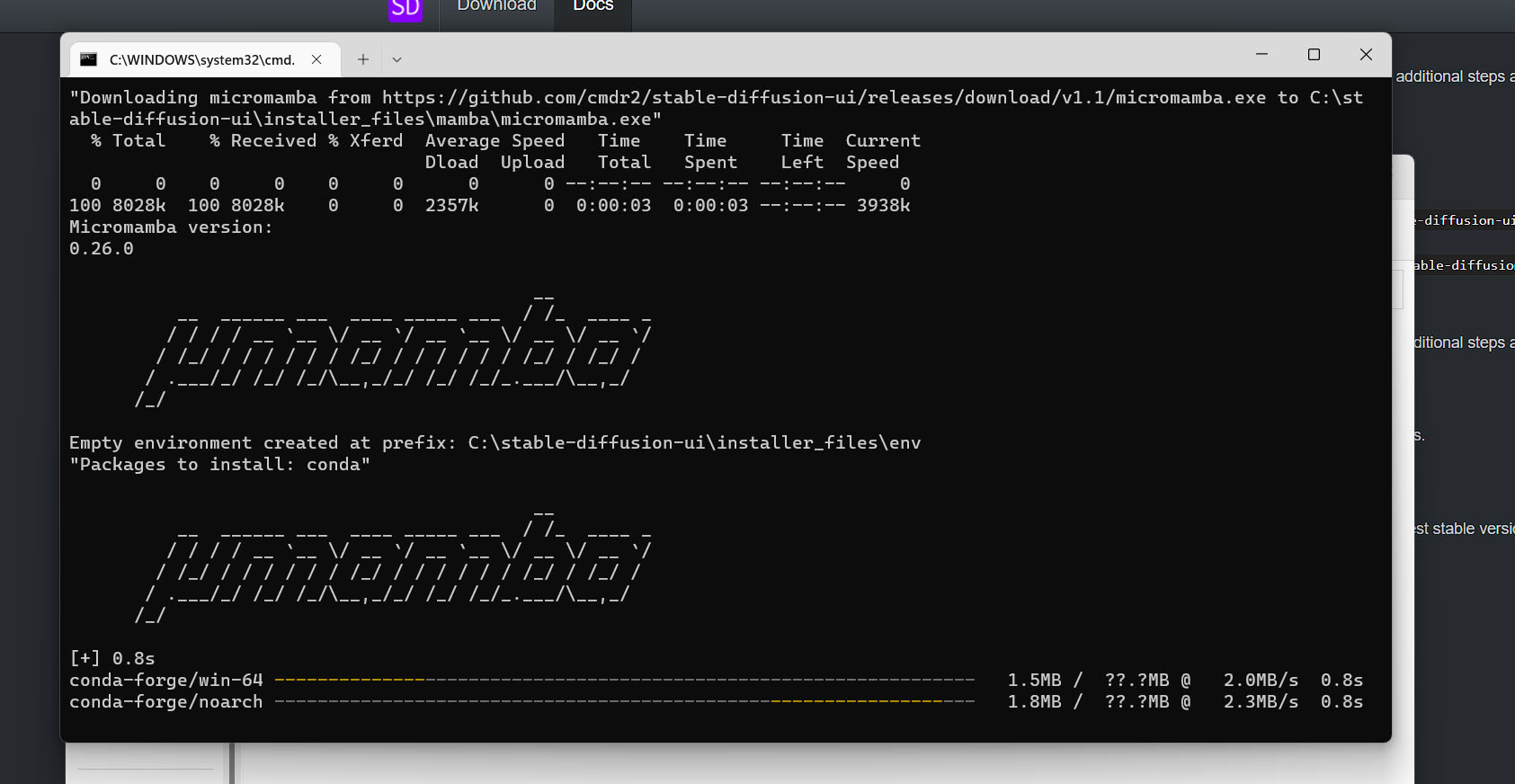

La instalación es bastante directa, un script que se descarga en un pequeño ZIP y éste hará todo por nosotros.

Es importante que lo instalen en el raíz de un disco, sea C o D o el que fuere, así puede manejar mejor los nombres largos de archivo o fallará.

El script de ejecución también es el de actualización así que, teóricamente, cada vez que inicien hará una verificación de versión y actualizará paquetes.

Está todo hecho en Python así que usará pip y otras cosas para instalar paquetes más o menos donde se le canta al script. Para desinstalar sólo borran esta carpeta, seguro quedarán cosas de Python repartidas por todo su usuario ![]()

Inicio

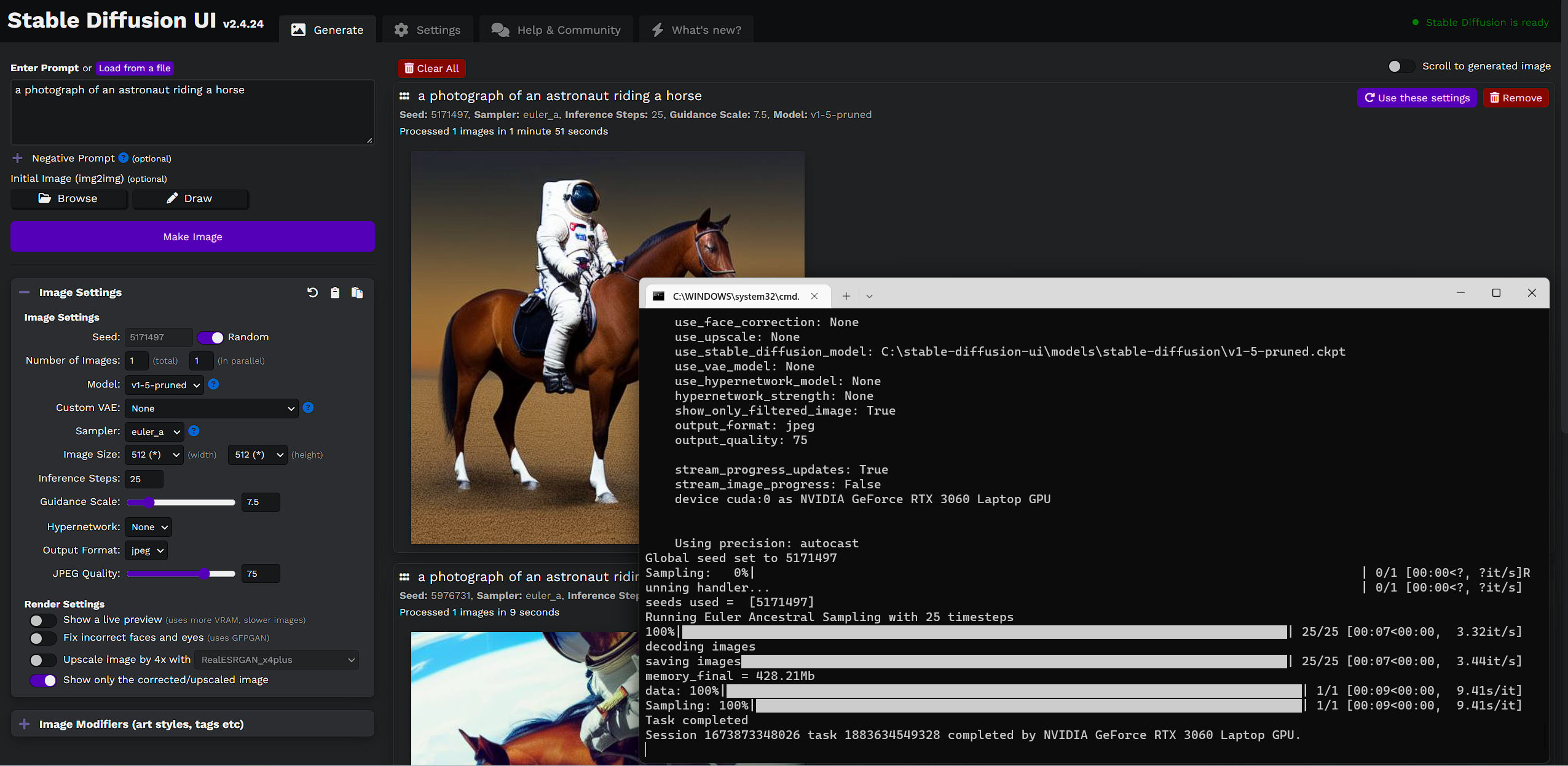

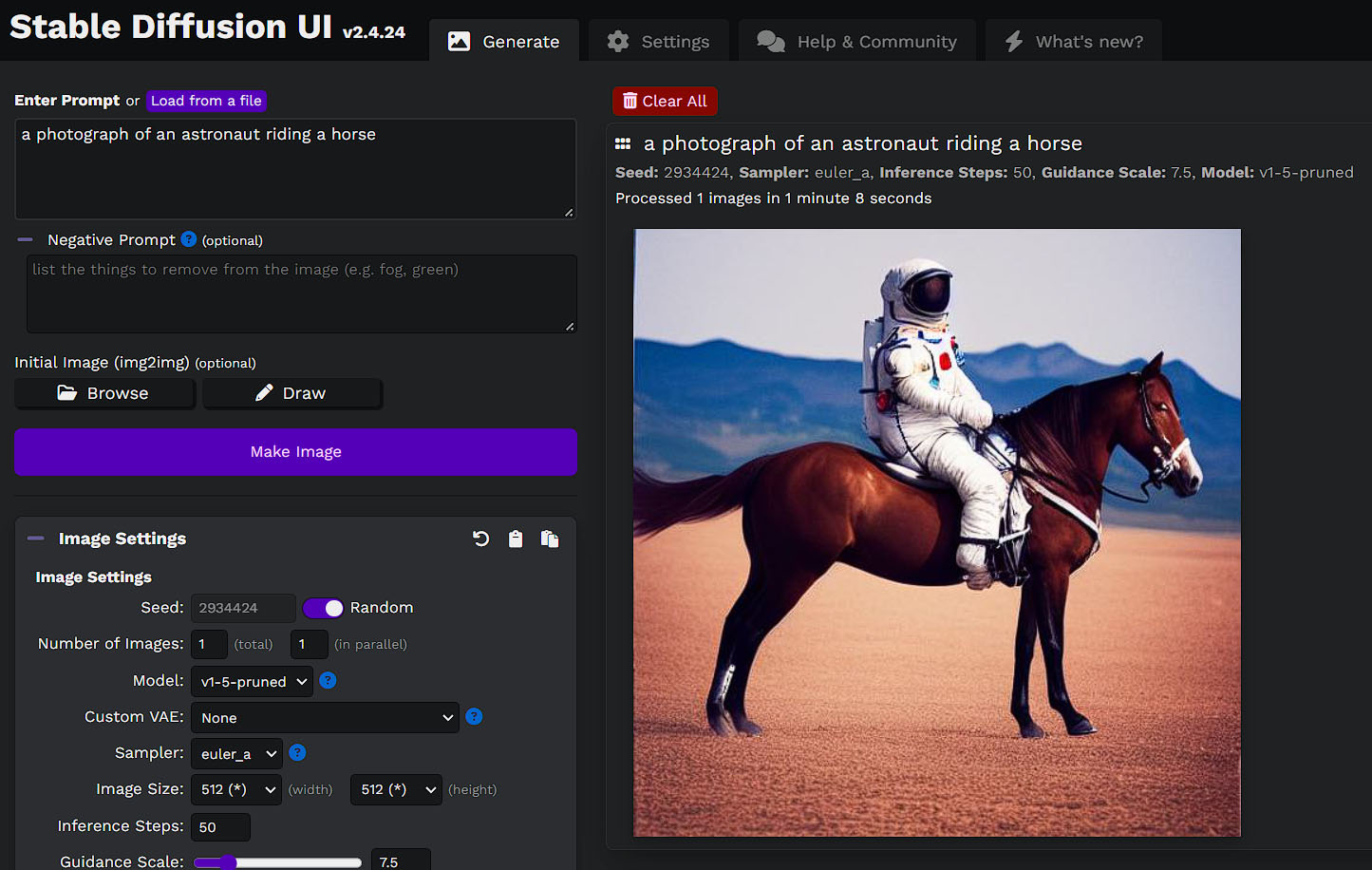

Ejecutando el mismo script cmd puede iniciarse, se abrirá en el browser por defecto la url localhost:9000 que es el puerto que usará a modo de servidor.

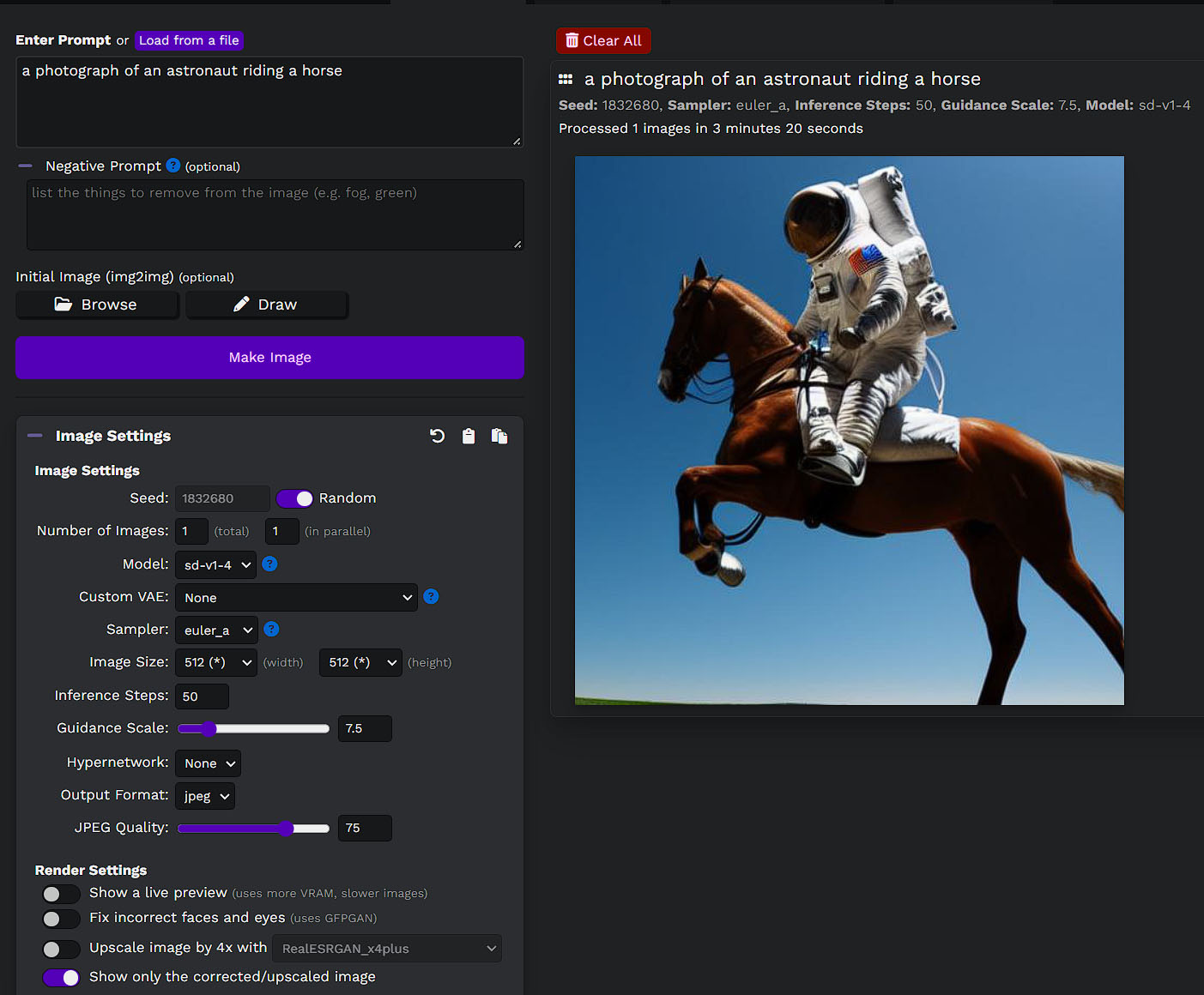

De entrada Stable Diffusion viene con el modelo 1.4 listo para usar, es algo viejo pero es el más estable en una PC normal, no requiere grandes cantidades de RAM ni VRAM por lo que "anda". El resultado de los prompts que tiren será patético porque es un modelo con poco contenido.

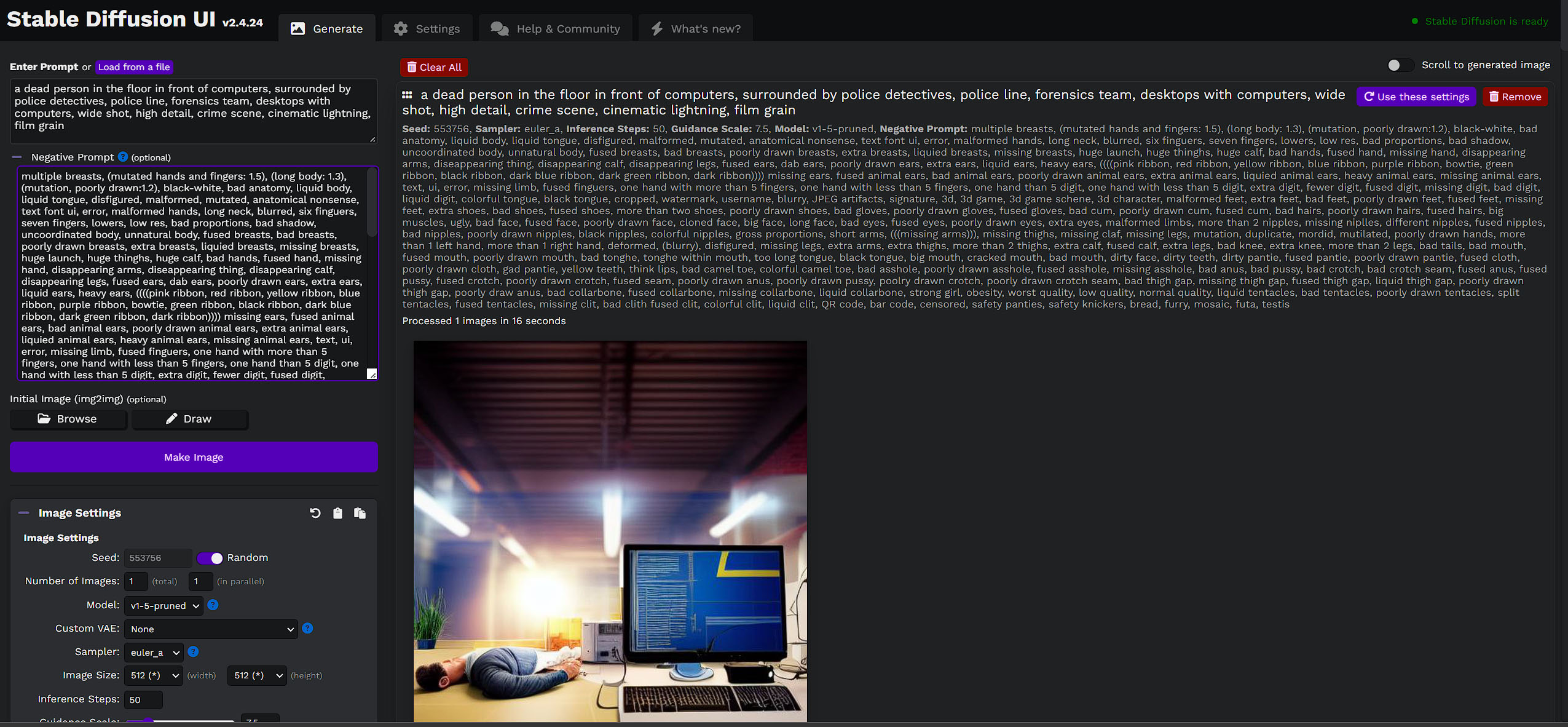

La pantalla ofrece una enorme cantidad de opciones para configurar la entrada y la salida, el cambio de resolución hará que uses más memoria y es el límite con el que podrás jugar hasta reventar tu propia PC ![]()

Es normal que todo se frene, no recomiendo usar esto en los momentos en que estés haciendo un trabajo relevante con tu computadora porque, bueno, usa toda la RAM.

¿Funciona? Sí, por suerte sí, ante el primer intento, pero ahora vamos a lo complicado: los modelos

Modelos

La versión 1.4 del modelo de Stable Diffusion es, como les dije, conservadora en uso de memoria RAM pero bastante malo en resultados.

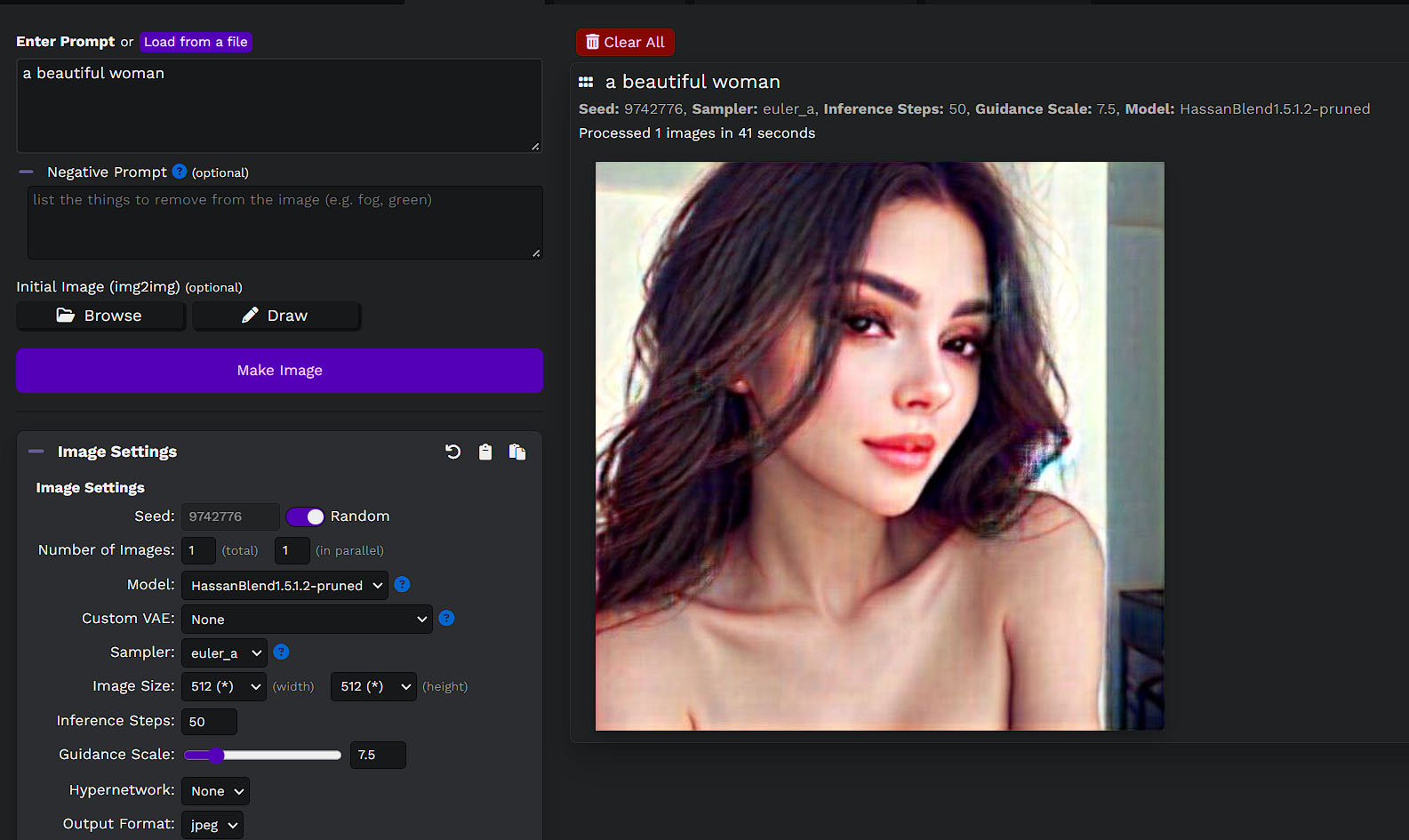

Sin mucho esfuerzo podemos conseguir la versión 1.5 y se instala dejando el archivo .ckpt en la carpeta de modelos de su instalación.

Aquí empieza el ruido que todavía no decifro completamente, obviamente tenemos un modelo más pequeño de 4GB que es el que recomiendo porque usa menos VRAM, el otro es de 7.7GB que, supongo, sirve para equipos con una placa de video mucho mayor que la mía. Si andan con una RTX 4000 no creo que sea un problema usar ese, para mi RTX 3060 con 6GB de VRAM uso el primero.

Pero ¿ Y Stable Diffusion 2? Hay más opciones pero no logré hacer funcionar ninguna, todas revientan.

Stable Diffusion 2.0 code

768x768 model

512x512 base model

Depth model

4x upscaler

Si ustedes pueden hacerlo funcionar cuenten qué hicieron, si descargaron todo y lo tiraron ahí o si sólo usando uno o dos archivos, yo probé con el de 512 y el de 768 pero tira mil errores incomprensibles para mí.

Los otros modelos

Ahora bien, Ale Caro me pasó un enorme listado de modelos que alguien está compilando y ahí aparecieron las sorpresas.

La mayoría de los modelos "alternativos" son para porno (no todos! aclaro!), hay gente con muchas necesidades insatisfechas. Más adelante haré una nota específicamente sobre este movimiento porque me parece una locura que vale el análisis.

Lo interesante es que Stable Diffusion hace un esfuerzo enorme en no dibujar nada que pueda ser ponográfico, limitando sus modelos "estrictamente" según dicen, pero como cualquiera con hardware suficiente puede crear sus propios modelos, aquí hay una lista enorme.

Nombres como "Waifu", "Hentai Diffusion", "Pyro's Blowjob Model", "Lewd Diffusion", y cosas que mejor no escribo aquí porque me van a cancelar 😁están todas ahí disponibles y son la mayoría de modelos que hay.

Cada gordo con sombrero Fedora viviendo en el sótano de su madre parece haber comprado suficientes GPUs para entrenar modelos numéricos de su porneta favorita.

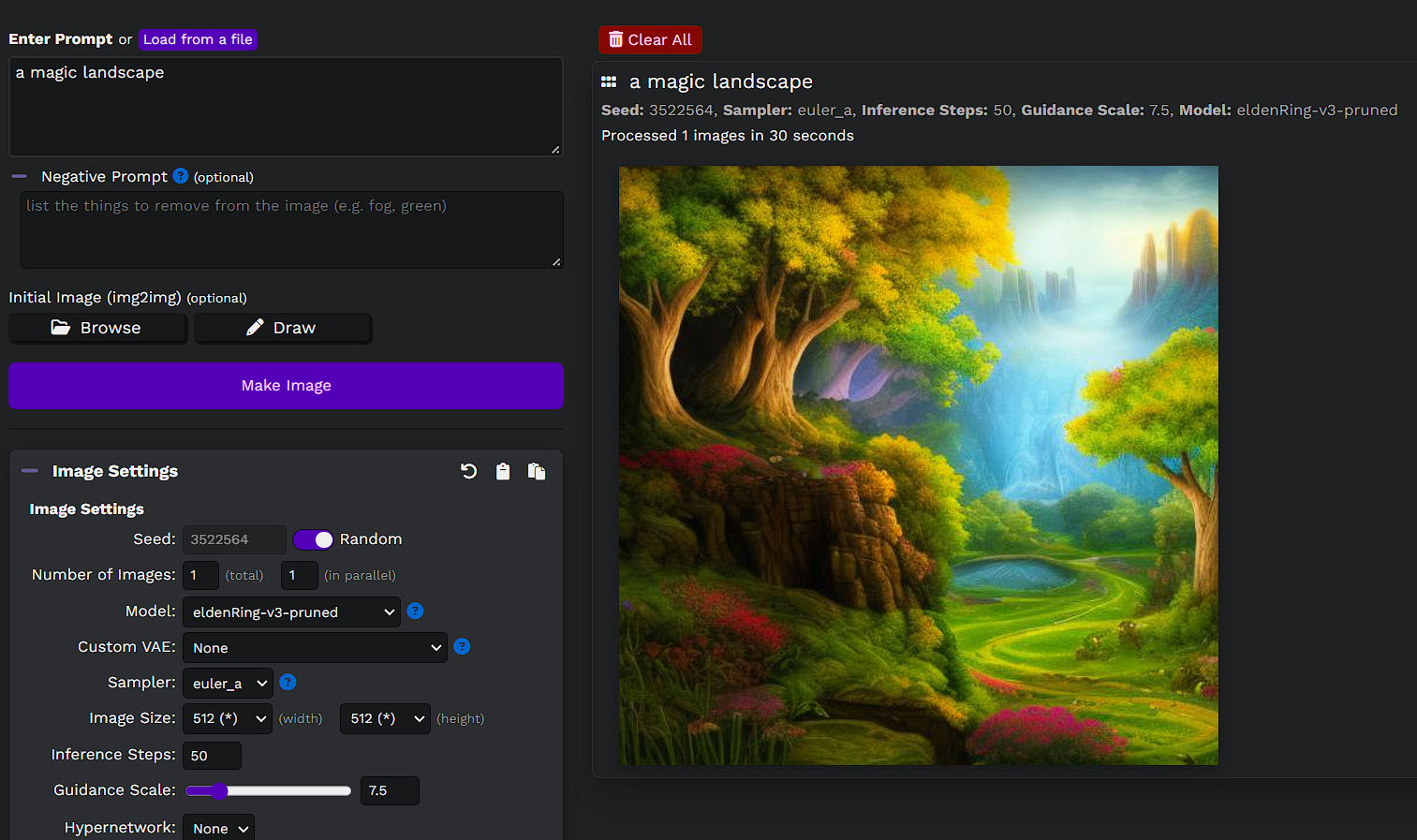

Ahora bien, también hay modelos totalmente inocentes y muy interesantes, aquí encontré uno de Elden Ring, así que podés generar lo que quieras basado en el juego ¿? qué se yo, es interesante 😛

También vi de Arcane, de DC o con varios estilos de comics que el SD original no tiiene. Es decir, no todo es porneta pero hay mucha.

Para nardos: hay uno entrenado con imágenes del JWST y cosas así del espacio y uno puede generar galaxias nuevas ![]()

Cerrando

Aquí les dejo más guías con info detallada, a mi me supera porque no tengo el tiempo para dedicarle que me gustaría.

Personalmente veo más lógico pagar por un servicio ya preparado si lo que querés hacer es crear contenido y ya. Si querés entrenar modelos, entonces dale duro por este lado porque es el camino.

Stable Diffusion es open source y por eso uno puede instalar lo que quiera, la clave está en el entrenamiento de modelos.

Pero ahí justamente es donde los costos se van al cuerno y puede hacerlo aquél que tenga el hardware necesario. Por mi parte sólo tengo suficiente para curiosea, probar, jugar, aprender y después, si quiero imágenes bien hechas, sigo con mi cuenta de MidJourney 😁🤷♂️

Hay otras opciones para instalar SD con otros installers no oficiales, uno que parece anda muy bien es Automatic 1111 y lo consiguen aquí, es más complejo el proceso de instalación pero parece que es más fácil hacerlo funcionar con SD-2.1

Otros posts que podrían llegar a gustarte...

Comentarios

-

Instalé Stable Diffusion hace un par de meses en local. Con mi GTX 750ti no andaba y usaba CPU, tardaba 30/25 minutos en sacar una imágen. Cambié la placa por una GTX 3060 y ahora si, 15 segundos por imagen. Usé la general, está interesante lo de entrenarla con tu cara o alguna otra cosa, no lo hice aún.

-

¡De nada!

¡Que guacho! ¡Usaste mi negative prompt que tanto me costó hacer para la imagen final!

Ahora, te faltó lo de disney... y el pornacho ¡No vayan a pensar que fui a buscar eso! ¡¡¡¿EH?!!!

-

Genial! habia oido de este metodo que lo hacias vos con tu placa, yo me hice un par con mi caripela y tratando que me genere una Buenos Aires al estilo URSS con el obelisco y todo pero use el metodo ese de google collab con las maquinas de ellos y linkeando el onedrive para que me mande todo ahi de una.

-

Fabio Baccaglioni dijo:

Cada gordo con sombrero Fedora viviendo en el sótano de su madre parece haber comprado suficientes GPUs para entrenar modelos numéricos de su porneta favorita.

Implicando que no sea gente que ya tenia un rig minero armado para minar criptos (o que le compro GPUscasi fundidasusadas a los primeros).

Fabio Baccaglioni dijo:

Personalmente veo más lógico pagar por un servicio ya preparado si lo que querés hacer es crear contenido y ya.

O aprovechar Google Colab mientras aun se pueda como dijo Andres.